At AI-assistenten din kan bestille en avtale for deg, men hva med en meningsfull samtale? Shutterstock / Bas Nastassia

At AI-assistenten din kan bestille en avtale for deg, men hva med en meningsfull samtale? Shutterstock / Bas Nastassia

Google nylig avduket den siste samtale AI, kalt Duplex. Dupleks høres ut som en ekte person, komplett med pauser, “umms” og “ahhs”.

Teknigiganten sier at den kan snakke med folk på telefonen for å avtale og sjekke åpningstider for virksomheten.

I innspilte samtaler som ble spilt på avdukingen av Google, snakket den sømløst med menneskene i mottakeren, som virket helt uvitende om at de ikke snakket med en annen person.

Disse samtalene forlot teknologiorienterte publikum på Google viser gisende og jublende. I ett eksempel forsto AI til og med når personen den snakket med ble blandet, og klarte å fortsette å følge samtalen og svare riktig når det ble fortalt at den ikke trengte å gjøre en bestilling.

Fremveksten av AI-assistentene

Hvis du har brukt noen av de tilgjengelige taleassistentene, for eksempel Google Home, Apples Siri eller Amazon Echo, kan denne fleksibiliteten overraske deg. Disse assistentene er notorisk vanskelig å bruke til noe annet enn standardforespørsler som for eksempel å ringe en kontakt, spille en sang, gjøre et enkelt websøk eller stille en påminnelse.

Når vi snakker med disse nåværende generasjons assistenter, er vi alltid klar over at vi snakker med en AI, og vi skreddersyr ofte det vi sier deretter, på en måte som vi håper maksimerer sjansene våre for å få det til å fungere.

Men menneskene som snakket med Duplex hadde ingen anelse om. De nølte, trakk tilbake, hoppet over ord og endret til og med fakta halvveis gjennom en setning. Duplex savnet ikke takten. Det så ut til å forstå hva som foregikk.

Les mer: Smarte høyttalere kan være et tips for hjemmeautomatisering

Så har fremtiden kommet tidligere enn noen forventet? Er verden i ferd med å bli full av online (og på telefon) AI-assistenter som chatter lykkelig og gjør alt for oss? Eller verre, vil vi plutselig bli omringet av intelligente AI-er med egne tanker og ideer som kanskje eller ikke inkluderer oss mennesker?

Svaret er et klart "nei". For å forstå hvorfor, hjelper det å ta en rask titt under panseret på hva som driver en AI som denne.

Dupleks: hvordan det fungerer

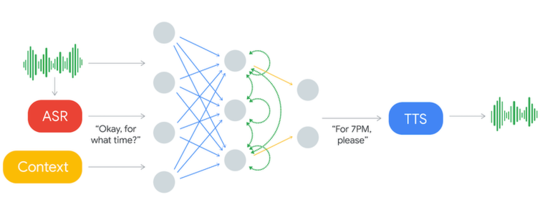

Dette er hva Tosidig AI-system ser ut som.

Innkommende lyd blir behandlet gjennom et ASR-system. Dette produserer tekst som blir analysert med kontekstdata og andre innspill for å produsere en svarstekst som leses høyt gjennom tekst-til-tale-systemet (TTS). Google

Innkommende lyd blir behandlet gjennom et ASR-system. Dette produserer tekst som blir analysert med kontekstdata og andre innspill for å produsere en svarstekst som leses høyt gjennom tekst-til-tale-systemet (TTS). Google

Systemet tar "input" (vist til venstre) som er stemmen til personen det snakker med på telefonen. Stemmen går gjennom automatisk talegjenkjenning (ASR) og blir konvertert til tekst (skrevne ord). ASR er i seg selv et avansert AI-system, men av en type som allerede er i vanlig bruk i eksisterende stemmeassistenter.

Teksten blir deretter skannet for å bestemme hvilken type setning den er (for eksempel en hilsen, en uttalelse, et spørsmål eller en instruksjon) og trekke ut all viktig informasjon. Nøkkelinformasjonen blir da en del av konteksten, som er ekstra innspill som holder systemet oppdatert med det som er sagt så langt i samtalen.

Teksten fra ASR og konteksten blir så sendt til hjertet av Duplex, som kalles et kunstig nevralt nettverk (ANN).

I diagrammet over vises ANN av sirklene og linjene som forbinder dem. ANN-er er løst modellert på hjernen vår, som har milliarder av nevroner koblet sammen til enorme nettverk.

Ikke helt en hjerne, ennå

ANN-er er imidlertid mye enklere enn hjernen vår. Det eneste som denne prøver å gjøre er å matche inndataordene med en passende respons. ANN lærer ved å bli vist utskrifter av tusenvis av samtaler av mennesker som bestiller på restauranter.

Med nok eksempler lærer den hva slags inngangssetninger man kan forvente av personen den snakker med, og hva slags svar man kan gi for hver enkelt.

Tekstresponsen som ANN genererer blir deretter sendt til en tekst-til-tale-synthesizer, som konverterer den til talte ord som deretter spilles til personen på telefonen.

Nok en gang er denne TTS-synthesizeren en avansert AI - i dette tilfellet er den mer avansert enn den på telefonen din, fordi den høres nesten ikke ut fra hva som helst vanlig stemme.

Det er alt du trenger. Til tross for at det er topp moderne, er hjertet i systemet egentlig bare en teksttilpassingsprosess. Men du kan spørre - hvis det er så enkelt, hvorfor kunne vi ikke gjøre det før?

Et innlært svar

Faktum er at menneskespråk, og de fleste andre ting i den virkelige verden, er for varierende og uordnede til å kunne håndteres godt av vanlige datamaskiner, men denne typen problemer er perfekt for AI.

Legg merke til at output produsert av AI helt avhenger av samtalene det ble vist mens det lærte.

Dette betyr at forskjellige AI-er må opplæres for å gjøre bestillinger av forskjellige typer - slik at for eksempel en AI kan bestille restauranter og en annen kan bestille håravtaler.

Dette er nødvendig fordi typer spørsmål og svar kan variere så mye for forskjellige typer bestillinger. Dette er også hvordan Duplex kan være så mye bedre enn de generelle stemmeassistentene, som trenger å håndtere mange typer forespørsler.

Så nå skal det være tydelig at vi ikke kommer til å ha tilfeldige samtaler med AI-assistentene snart. Faktisk er alle våre nåværende AI-er egentlig ingenting mer enn mønstermatchere (i dette tilfellet matchende mønster av tekst). De forstår ikke hva de hører, eller hva de ser på, eller hva de sier.

Mønster matching er en ting hjernen vår gjør, men de gjør også så mye mer. Nøkkelen til å skape kraftigere AI kan være å låse opp flere av hjernehemmelighetene. Vil vi? Det er det Et annet spørsmål.![]()

Om forfatteren

Peter Stratton, postdoktor, Universitetet i Queensland

Denne artikkelen er publisert fra Den Conversation under en Creative Commons-lisens. Les opprinnelige artikkelen.